Juan Carlos Hernández Peña, profesor y experto en regulación de inteligencia artificial: "La ley de la Unión Europea está pensada para garantizar los derechos fundamentales de las personas"

La Universidad reúne a investigadores de distintos ámbitos en una jornada para debatir sobre ética e inteligencia artificial

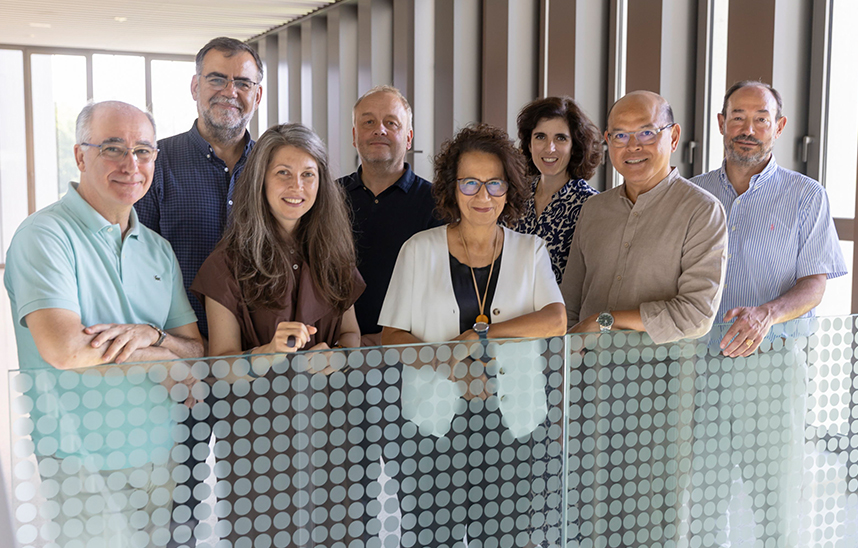

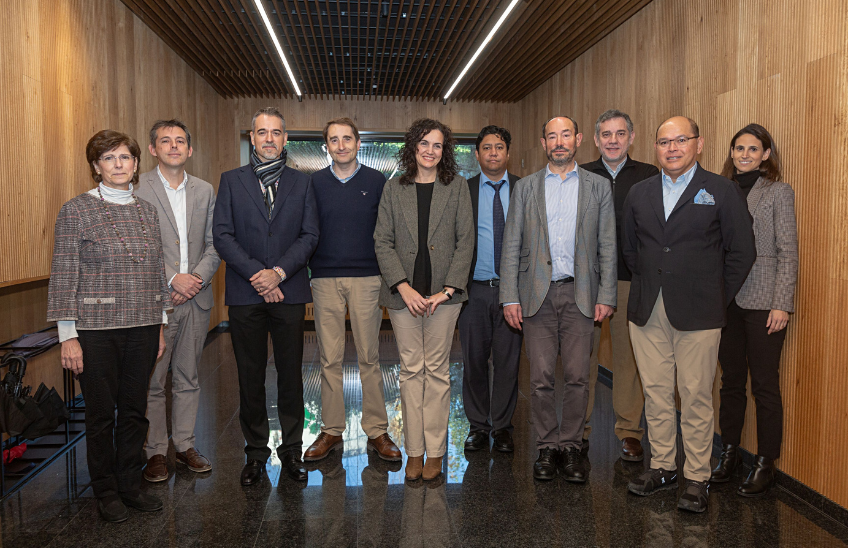

FotoManuel Castells/Los investigadores que participaron en la jornada organizada por la Universidad de Navarra, de izquierda a derecha: Pilar León, Luis Echarte, Rubén Armañanzas, Diego Borro, Paloma Grau, Juan Carlos Hernández Peña, Jesús López Fidalgo, Ramón Salaverría, Alejo Sison y Marta Ormazábal.

19 | 12 | 2023

El impacto de la inteligencia artificial (IA) en los gobiernos corporativos, la transformación digital en los ámbitos de trabajo, la ética de la inteligencia artificial y su aplicación a los negocios, la desinformación y la reciente regulación aprobada por la Unión Europea. Estos fueron algunos de los temas que se pusieron sobre la mesa en la jornada “Time to Share: Ética e Inteligencia Artificial” impulsada por el Instituto de Ciencia de los Datos e Inteligencia Artificia (DATAI) de la Universidad de Navarra. La jornada reunió a casi un centenar de expertos de distintos ámbitos que reflexionaron sobre “líneas rojas” en el uso de la inteligencia artificial, sobre el valor de la transparencia y la innovación pero también el de preservar la dignidad de la persona y la seguridad. Una conclusión destacó durante toda la jornada: no todo lo técnicamente posible, es admisible.

“La ley busca que el uso de la inteligencia artificial en la Unión Europea sea segura”, afirmó el profesor de la Facultad de Derecho, Juan Carlos Hernández Peña. El profesor ha desarrollado buena parte de su ámbito de investigación sobre la regulación y legislación de la inteligencia artificial, y aseguró: “La normativa aprobada por la Unión Europea no está pensada para desarrolladores ni para medir el impacto del uso de la IA, sino para garantizar los derechos fundamentales de las personas”.

Según explicó Juan Carlos Hernández Peña, el reglamento divide los sistemas de IA en distintos tipos de riesgo, según sea su desarrollo, implantación e incluso su exportación a otros países. De este modo se establecen sectores donde está prohibido el uso de la IA; otros denominados de alto riesgo, que están sujetos a muchas obligaciones y controles; y otros que se consideran de riesgo mínimo, donde se van a establecer sistemas de transparencia, códigos de conducta o se aplicarán los modelos de ‘compliance’ tradicionales. Hernández Peña señaló que, con la entrada en vigor de la normativa, Chat GPT o Gemini van a estar sujetos al control por parte de una oficina especial en IA de la Unión Europea. La ley va a designar autoridades nacionales de supervisión y regulación de la inteligencia artificial en cada país.

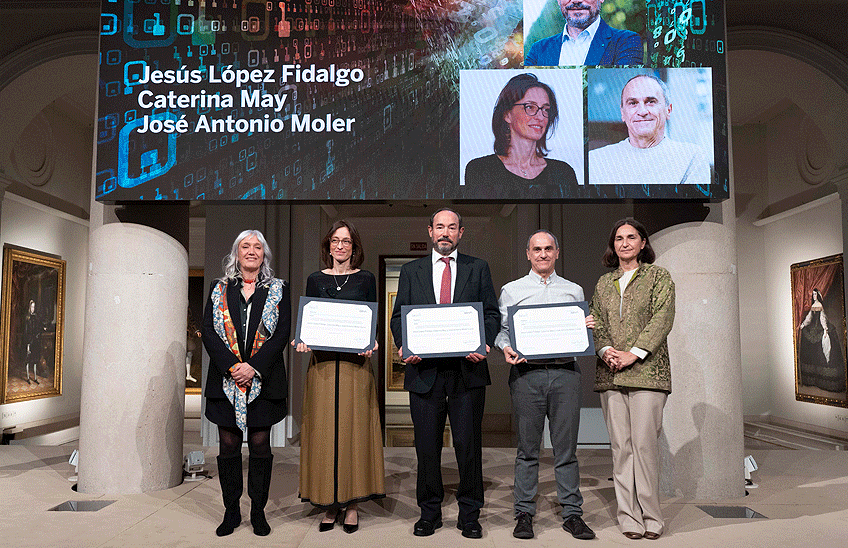

La vicerrectora de Investigación y Sostenibilidad de la Universidad de Navarra, Paloma Grau, y el director de DATAI, Jesús López Fidalgo, fueron los encargados de presentar el encuentro que se desarrolló en el campus de la Universidad en San Sebastián. “La ética y la inteligencia artificial es un tema clave para la Universidad. Supone un encuentro y un esfuerzo mutidisciplinar en que el que debemos profundizar para ofrecer a nuestros alumnos la mejor preparación. Muchas de estas herramientas ya están en nuestras aulas y, desde la Universidad, queremos formar profesionales y futuros directivos en cuestiones éticas a las que esta tecnología nos enfrenta”, afirmó la vicerrectora.

Formación para el buen uso de la IA en las organizaciones

Óscar González-Peralta, senior lecturer del departamento de Ética Empresarial del IESE Business School, abogó por reforzar la formación de las personas implicadas en el desarrollo de la inteligencia artificial y su aplicación en los modelos de negocio de las organizaciones, desde los directivos a los ingenieros y desarrolladores de sistemas. Óscar González-Peralta respaldó una formación basada en principios como la dignidad de la persona, la privacidad, la seguridad, la transparencia pero también en la prevención del daño. “Hay que poner el foco en las personas para que tengan esa prudencia y prever esos sesgos”, afirmó.

“No existe una solución única por parte de la comunidad internacional sobre el uso de la IA pero es la primera vez que nos dice que no todo lo técnicamente posible es admisible”, dijo, refiriéndose a la regulación europea. “Falta la implicación de EEUU y China en esta regulación, pero hay una sensibilidad, unas líneas rojas que se van marcando”, añadió.

Alejo Sison, profesor de la Facultad de Económicas, centró su intervención en cómo albergar un ámbito para las virtudes en plena transformación del trabajo del mundo digital. Estableció distintos paralelismos y diferencias entre el mundo humano y el de las máquinas y puntualizó que las personas tienen la capacidad de detectar la esencia de las cosas, de apreciar las emociones y de decidir cómo utilizar los datos que les brinda una herramienta. “La ética surge cuando interactuamos con la máquina. A veces pensamos que hay una única dimensión: o el pleno control humano o plena automatización. pero debe haber dos dimensiones: máximo control y máxima automatización, así podremos mejorar”.